2024年12月16日、NEDOは、「人工知能活用による革新的リモート技術開発プロジェクト」において、東京大学大学院工学系研究科(以下、東京大学)、産業技術総合研究所(以下、産総研)、イームズロボティクス、NTTドコモが、リモートでオペレーターが安全かつ迅速に現場の状況把握ができる革新的なドローン運用技術を開発したことを発表した。

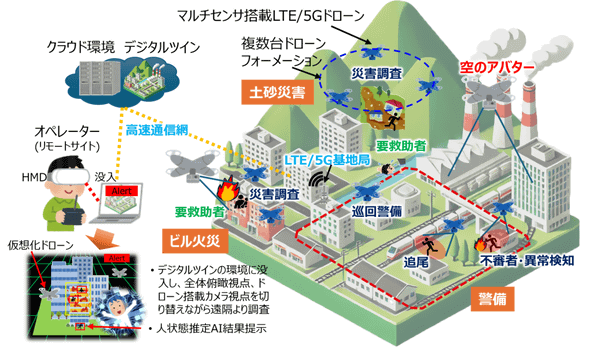

革新的ドローンリモート技術は、危険性や緊急性を有する現場の迅速な状況把握が要求される警備分野や消防・防災分野において、1人のオペレーターによる自律分散協調飛行するドローン群を運用した高度な調査活動を可能にする。具体的には、複数台のドローンで撮影した高解像度映像やLiDARセンサーから得た情報を統合処理することにより、現場の状況を即座にデジタル空間上に再現する。

2024年10月16~18日および12月4~6日に福島ロボットテストフィールド(福島県浪江町)において、警備業務を想定したシナリオに沿って実証を行い、オペレーターの安全を確保した上で迅速な初動対応の実現に貢献できる見通しを得た。事業終了後には、実用化に向けた開発・実証を進め、あらゆる場面でドローンを利活用できる社会の実現を目指す。

近未来のスマートシティーでは通信網で通信接続された複数台の遠隔ドローンを用いて、自律的またはリモート操作による防災、警備、点検などでの活用が想定される。現状、防災や警備などの迅速な対応を要する現場でドローンを活用する場合は、操縦者が近距離でドローンからの映像を確認しながら1台のドローンを操縦し、操縦者あるいは補助者がドローンからの映像を見て被災状況を把握している。労働力不足のなか、高度なドローン運用が可能な多数の専門要員の確保が課題となっている。

飛行中に得た映像からAIにより人などの状態を推定し、XRなどで提示された情報から、特に不審者や要救助者の識別が可能となれば、操縦者および補助者の負荷は大幅に軽減され、安全かつ効果的なドローン運用と効率的な警備や救助活動などが期待できる。

人工知能活用による革新的リモート技術開発プロジェクトの一環として、東京大学、産総研、イームズロボティクス、NTTドコモは、2021年度からAI・XR活用による空のアバター(※1)を実現する「革新的ドローンリモート技術」の研究開発に取り組んでいる。

2023年度の消防・防災分野における実証実験に引き続き、2024年10月および12月には福島ロボットテストフィールドにおいて警備分野における実証実験を行った。

※1 空のアバター:マルチコプター型ドローンに対して、オペレーターが遠隔からあたかも自分の分身のようにドローンを遠隔操作できる仕組みの総称。

今回の成果

革新的ドローンリモート技術の開発

・複数台のドローンによるフォーメーション飛行、相互衝突回避、対象物上空旋回飛行を可能にする自律分散協調飛行(※2)技術

機体間通信により他機体の衛星利用測位システム(GPS)位置・速度情報を逐次取得し、各機体における目標地点からの引力、他機体との引力、斥力(せきりょく)、回転力などの合力を計算し、各機体が自律的に移動制御を行うことで協調的な飛行を実現。

※2 自律分散協調飛行:複数のドローンが中央の司令塔なしに自律的に判断しつつ、機体間通信を介して相互に連携しながら分散的に飛行する技術。本事業では、同じ目的地に向かって飛行するフォーメーション飛行、相互衝突回避機能、対象物上空旋回飛行、1人のオペレーターによる複数ドローンの群移動操作などを実現している。

・広角カメラ、LiDARセンサー、環境センサー、920MHz機体間通信機能、LTE/5G通信機能、自律制御用コンピューターなどを搭載したLTE/5G搭載マルチセンサードローン

イームズロボティクス製ドローン「UAV-E6106FLMP2」をベースに、マルチセンサー、各種通信機器、自律分散協調飛行アルゴリズムなどを搭載した機体を開発。自律分散協調飛行機能に、広角カメラ映像の高圧縮低遅延伝送、3次元カラー点群データの生成と伝送、ROS2システム(※3)による機体間、機体・基地局間の情報伝達を可能としている。

※3 ROS2システム:ロボット開発用のオープンソースのプラットフォームで、複数のコンピューターやデバイスがネットワークで接続され、協力してロボットを制御できるように設計されている。本事業では、各ドローン搭載の制御用コンピューター、地上基地局の操作PC間で、ROS2システムによる情報連携を行っている。

・各ドローンからの高解像度映像を低遅延でクラウドに伝送し、クラウド上で要救助者や不審者を認識する人状態推定AI技術

NTTドコモが提供するクラウド(docomo MEC)上で、ドローン3台全周囲における人の検出、人物行動推定(要救助者、不審者など)のAI処理をリアルタイムに実現する技術を開発。

・ドローンに搭載したLiDARセンサーと可視カメラ画像による高速な3次元カラー化技術

飛行中の複数ドローンから地上をLiDARセンサーでスキャンし、GPS情報を併せて取得した点群をつなぎ合わせることで高精度な3次元の環境モデルを作成する。同時に、カメラからのカラー画像を用いてドローン搭載コンピューター上で点群のカラー化まで処理。地上対象物の少ない環境、揺れの大きなドローンから安定した3次元カラー点群の生成を実現している。

・デジタルツインの環境にオペレーターが没入し、全体俯瞰(ふかん)視点、ドローン搭載カメラ視点を切り替えながらXR提示される現場の状況を把握可能な遠隔操作インターフェース技術

ドローンによる遠隔からの現場状況の把握において、本事業では現場のデジタルツインの環境(※4)を用意し、オペレーターがその中にヘッド・マウント・ディスプレーと仮想現実(VR)コントローラーで没入することで、XR提示(※5)される各種情報(状態推定AIからの結果、環境センサー情報、ドローンの状態など)を俯瞰しながら確認できる。さらに仮想表示されたドローンを選択することでドローン視点(1人称視点)による遠隔操縦が可能なシステムを構築している。

※4 デジタルツインの環境:デジタルツインは、現実世界を仮想デジタル空間に再現した「デジタルの双子」を作り、仮想空間で現実の動きや状態をリアルタイムに再現することで、さまざまな分野で効率化やリスク管理を実現する技術。本事業では、現場の環境をドローン搭載のLiDARとカメラにより高速に3次元化し、デジタルツインの環境として利用する技術を開発している。

※5 XR提示:XRとはVR(Virtual Reality:仮想現実)やAR(Augmented Reality:拡張現実)、MR(Mixed Reality:複合現実)などの総称。本事業では、これらの技術を用いて情報や映像を提示することを指す。

革新的ドローンリモート技術によるドローン機械警備の実証

今回開発した革新的ドローンリモート技術の機械警備への応用を検証するため、2024年10月16~18日および12月4~6日に、ALSOK福島の協力のもと、福島ロボットテストフィールドにおける従来の機械警備を拡張する3台のドローンを活用した警備運用シナリオに沿って、以下の実証を行った。

1)自律分散協調飛行技術による複数ドローンの自動巡回警備と相互衝突回避(図1〔1〕〔2〕)

2)クラウド上人状態推定AIによる不審者の検出(図1〔3〕)

3)複数ドローンによる死角のない不審者上空旋回自動追跡(図1〔4〕〔5〕)

4)遠隔操作インターフェースからの不審者モニタリング、ドローンの操作(図3)

5)監視センターからの無線指示による警備員の現場への急行(図1〔6〕)

6)遠隔操作インターフェースからの自動離着陸(図1〔7〕)

本事業で開発した要素技術の統合実証により、現場へ警備員が駆けつけるまでの間、急行した複数のドローンにより不審者を見失わず追跡するなどの迅速で安全な初動対応が可能であることを確認した。

本事業終了後、東京大学、産総研、イームズロボティクス、NTTドコモは、今回実証した革新的ドローンリモート技術によるドローン機械警備への応用に加え、災害現場といった危険性・緊急性を有する現場の状況把握が必要とされる分野での実用化に向けた開発・実証を進めるとしている。