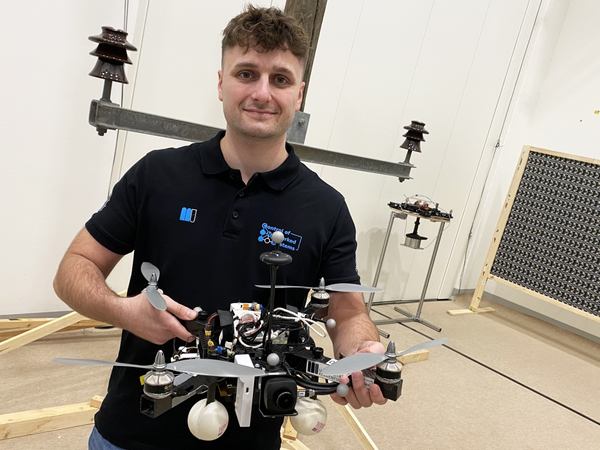

2025年4月8日、アイ・ディー・エス(以下、IDS)は、オーストリアのクラーゲンフルト大学の研究グループが、人工知能を活用した対象物相対ナビゲーションに基づくリアルタイム対応ドローンを設計し、IDS Imaging Development SystemsのuEye LEシリーズUSB3 Vision産業用カメラが搭載されたことを発表した。

エネルギー発電所や橋梁、工業団地などの重要インフラの点検において、ドローンはアクセスが困難な場所にも空中から到達できるため、有望なプラットフォームとして定着している。一方、検査対象物に対してドローンを正確にナビゲーションし、高解像度の画像データやその他のセンサーデータを確実に取得することが課題である。

オーストリア連邦気候政策・環境・エネルギー・モビリティ・イノベーション・技術省(BMK)の資金提供を受けたこの研究プロジェクトの一環として、ドローンは電柱と電柱の絶縁体を自律的に認識することが求められる。ドローンは絶縁体の周囲を3mの距離で飛行し、撮影を行う。カメラの記録を複数の点検飛行間で比較するには正確な位置特定が重要であり、その前提条件として、カメラが取得した未加工のセンサーデータから、対象物に関するいわゆる意味情報を抽出できる対象物相対ナビゲーションが必要になる。

意味情報は、カメラ画像のRAWデータを「理解可能な」形に変換し、環境を単に記録するだけでなく、関連するオブジェクトを正しく識別し位置特定することを可能にする。この場合、画像のピクセルは単なる独立した色値(例:RGB値)としてではなく、対象物の一部(例:絶縁体)として解釈される。従来のGNSSとは対照的に、このアプローチは空間内の位置だけでなく、例えば、ドローンは上部の絶縁体の左1.5mに位置しているなどと、検査対象物体に対する正確な相対位置と方向も提供する。画像処理とデータ解釈に遅延がないことで、ドローンは検査タスクの特定の状況や要件にリアルタイムでナビゲーションとインタラクションを調整することができる。

画像処理において、オブジェクト検出、オブジェクト分類、オブジェクト配置予測は人工知能を用いて行う。同グループのAIは意味情報により、検査対象のインフラを特定の再現可能な視点から検査することができる。大型インフラや谷地によるマルチパスやシャドウイングといったGNSSの一般的な問題も発生しないため、信号の劣化や安全リスクを回避できる。

ハードウェアのセットアップは、Pixhawk PX4オートパイロット、オンボードコンピュータとしてNVIDIA Jetson Orin AGX 64GB DevKit、IDS製のUSB3 Vision産業用カメラを搭載したTWINs Science Copterプラットフォームで構成される。

ドローンに搭載されたコンピューターはAIのトレーニングに使用されるコンピューターと比べて処理速度が不足しており、オンボードコンピューターでの使用を目的とした高性能AIモデルのさらなる最適化に関する課題だとしている。

カメラの性能は、検査システムのAIベースナビゲーションアルゴリズムに不可欠なものであり、Thomas Jantos氏は、uEye LEシリーズの省スペースでコスト効率の高いプロジェクトカメラ「U3-3276LE-C-HQ」モデルを選択した。搭載しているSony Pregius IMX265センサーは、300万画素クラスのCMOSイメージセンサーであり、3.19メガピクセル(2064×1544px)の解像度と最大58.0fpsのフレームレートを実現する。1/1.8インチのグローバルシャッターは、ローリングシャッターと比較して短い露光時間でも歪んだ画像を生成することがない。ナビゲーションカメラとして、uEye LEは検査対象物に対する相対位置と姿勢を計算するためにオンボードコンピューターが必要とする包括的な画像データを内蔵AIに提供。この情報に基づいてドローンはリアルタイムで姿勢を補正する。

IDSカメラはUSB3インターフェース経由でオンボードコンピュータに接続されている。IDS peak SDKを使用することで、カメラとその機能をROS(Robot Operating System)やドローンに統合することができる。

IDS peakは、効率的なRAW画像処理と、オートエクスポージャー、オートホワイトバランス、オートゲイン、画像ダウンサンプリングなどの記録パラメーターの簡単な調整を実現する。高度な自律性、制御、タスク管理、安全モニタリング、データ記録を確保するため、研究者たちはオープンソースのCNS Flight Stackをオンボードコンピューターで使用している。

CNS Flight Stackはナビゲーション、センサーフュージョン、制御アルゴリズム用のソフトウェアモジュールを含み、再現性がありカスタマイズ可能なタスクを自律的に実行する。「CNS Flight Stackのモジュール性とROSインターフェースにより、センサーと位置検出用のAIベースの「状態推定器」をスタック全体にシームレスに統合することができ、自律的なUAV飛行を実現しています。当アプローチの有効性は、クラーゲンフルト大学ドローンホール内の送電鉄塔周辺での点検飛行の例を用いて分析・開発されています」 とThomas Jantos氏は説明する。

センサーフュージョンによる正確で自律的な位置合わせドローンの高周波制御信号は、IMU(慣性測定ユニット)によって生成される。カメラデータ、LiDAR、またはGNSSとのセンサーフュージョンにより、ドローンのリアルタイムナビゲーションと安定化が可能になる。例えば、位置補正や検査対象物との正確な位置合わせなどに活用できる。クラーゲンフルトのドローンでは、PX4のIMUをEKF(拡張カルマンフィルター)の動的モデルとして使用している。EKFは、最後に確認された位置、速度、姿勢に基づいてドローンが現在あるべき位置を推定する。新しいデータ(IMU、GNSS、カメラなど)は最大200Hzで記録され、状態推定プロセスに組み込まれる。

このカメラは50fpsで1280×960pxの解像度でRAW画像を撮影する。カメラを起動すると、オートホワイトバランスとゲイン調整が1回実行され、オートエクスポージャーコントロールはオフのままになる。EKFは予測値と測定値を比較し、推定値を適切に補正。これにより、ドローンは安定性を維持し、高精度で自律的に位置を保つことができる。